人妖 sm

人妖 sm

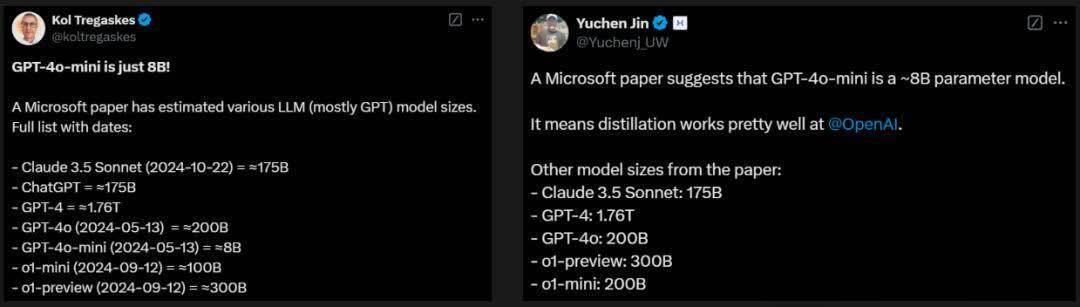

穿越重重迷雾,OpenAI模子参数终被揭开!一份来自微软华盛顿大学医疗论文,不测曝光了GPT-4、GPT-4o、o1系列模子参数。让系数东谈主战栗不已的是,GPT-4o mini仅8B。

谁能思到,微软在一篇医学领域的论文里,居然把OpenAI模子的参数全「曝光」了!

GPT-4参数约1.76万亿

GPT-4o参数约2000亿

GPT-4o mini参数约80亿

o1-preview参数约3000亿

o1-mini参数约1000亿

Claude 3.5 Sonnet参数约1750亿

接头东谈主员:参数均为估算值

让系数东谈主难以置信的是,GPT-4o系列的参数如斯少,mini版甚而只消8B。

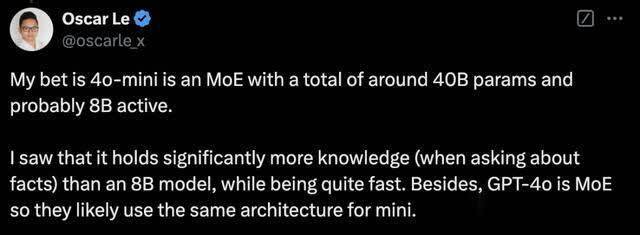

有网友猜想,4o mini是一个纯粹有40B参数的MoE模子,其中激活参数为8B。

因为,他发现4o mini赫然比8B模子学到了更多的知识,同时分运行速率很快。

此外,由于GPT-4o是MoE架构,是以OpenAI可能在mini版块上使用了疏通的架构。

另有网友讶异地示意,Claude 3.5 Sonnet参数竟等同于GPT-3 davinci。

这篇来自微软、华盛顿大学团队的论文中,发布了一个具有里程碑酷爱酷爱的评估基准——MEDEC1,专为临床笔记医疗造作检测和变嫌而预计打算。

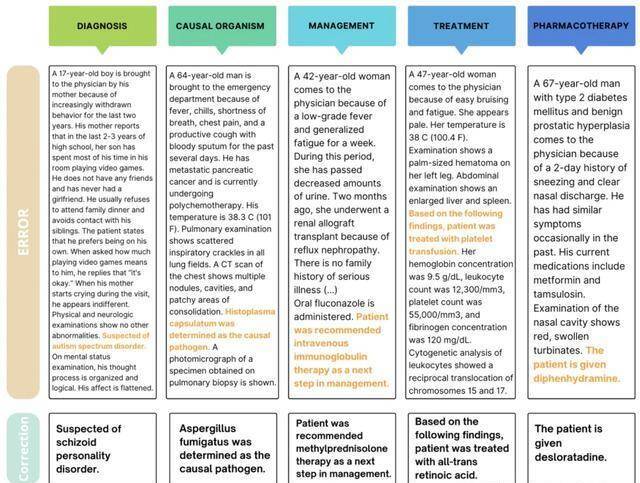

这项基准涵盖了五种类型的造作,包括会诊、束缚、调理、药物调理和致病因子。

MEDEC的数据来源,网罗了来自3家好意思国病院系统的488篇临床笔记,计较3,848篇临床文本。

值得一提的是,这些数据此前从未被任何LLM战争过,不祥确保评估真确性可靠性。目下,该数据集已被用于MEDIQA-CORR分享任务,以评估17个参与系统的说明。

得到数据集MEDEC后,接头团队对现时开始进的模子,包括o1-preview、GPT-4、Claude 3.5 Sonnet、Gemini 2.0 Flash等,在医疗造作检测和变嫌任务中进行了全面测试。

同期,他们也邀请了两位专科医师进行疏通的造作检测任务,最终将AI与东谈主类医师成果进行PK。

成果发现,最新LLM在医疗造作检测和变嫌方面说明不俗,但与东谈主类医师比拟,AI已经有着赫然的差距。

这也从侧面印证了,MEDEC是一个具有充分挑战性的评估基准。

论文讲了什么?

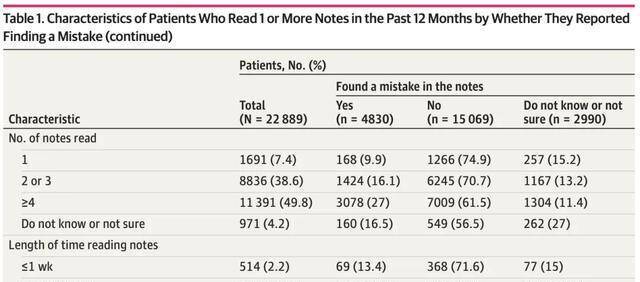

来自好意思国医疗机构的一项访问接头表现,每5位阅读临床笔记的患者中,就有一位回报发现了造作。

其中40%的患者觉得这些造作是严重的,最常见的造作类别与现时或已往的会诊相关。

与此同期,如今越来越多的医学文档任务(比如,临床笔记生成)均是由LLM去完成。

但是,将LLM用于医学文档任务的主要挑战之一,容易产生「幻觉」,输出一些臆造本色或造作信息,径直影响了临床决策。

毕竟,医疗无小事,一字之差可能关乎死活。

为了裁减这些风险,并确保LLM在医学本色生成中的安全性,严格的考证要领至关紧迫。这种考证需要相关的基准来评估是否不错通过考证模子好意思满系数自动化。

在考证经过中,一个枢纽任务是,检测和变嫌临床文本中的医学造作。

站在东谈主类医师的角度来讨论,识别和变嫌这些造作不仅需要医学专科知识和领域配景,偶然还需要具备丰富的教育。

而此前,大多量对于(学问性)造作检测的接头聚积会在通用领域。

为此,微软华盛顿大学团队引入了全新数据集——MEDEC,并对不同的跨越的LLM(比如,Claude 3.5 Sonnet、o1-preview和Gemini 2.0 Flash)进行了施行。

作家称,「据咱们所知,这是首个公开可用的临床笔记中自动造作检测和变嫌的基准和接头」。

MEDEC数据集

MEDEC数据集一共包含了3,848篇来自不同医学专科领域的临床文本的新数据集,标注任务由8位医学标注员完成。

如前所述,该数据集涵盖了五种类型的造作,具体包括:

会诊(Diagnosis):提供的会诊不准确

束缚(Management):提供的束缚下一步设施不准确

药物调理(Pharmacotherapy):推选的药物调理不准确

调理(Treatment):推选的调理决策不准确

致病因子(Causal Organism):指出的致病生物或致病病原体不准确

(注:这些造作类型是在分析医学委员会进修中最常见的问题类型后遴选的。)

上图1展示了,MEDEC数据集会的示例。每篇临床文本要么是正确的,要么包含一个通过以下两种要领之一创建的造作:要领#1(MS)和要领#2(UW)。

数据创建要领#1(MS)

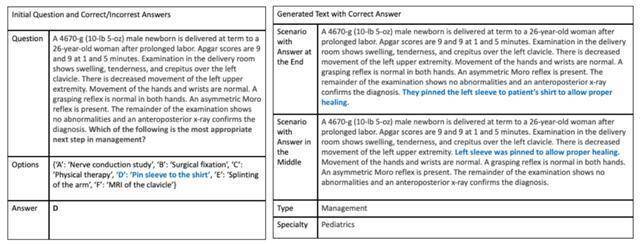

在此要领中,作家诈欺了MedQA蚁合中的医学委员会进修题目。

4位具有医学配景的标注员参考这些进修中的医学敷陈和多项遴荐题,在查对原始问题和谜底后,将造作谜底注入场景文本中,比肩斥包含造作或信息无极的问答对。

医学标注员治服以下准则:

使用医学敷陈多项遴荐题,将造作谜底注入场景文本中,并创建两个版块,分别将造作注入文本的中间或末尾。

使用医学敷陈多项遴荐题,将正确谜底注入场景文本中,以生成正确版块,如图2所示(包含正确谜底的生成文本)。

手动搜检自动生成的文本是否诚挚于原始场景过甚包含的谜底。

最终,接头东谈主员从两个不同的场景(造作注入文本中间或末尾)中,立时为每篇笔记遴荐一个正确版块和一个造作版块,构建了最终数据集。

数据创建要领#2(UW)

这里,作家使用了华盛顿大学(UW)三家病院系统(Harborview Medical Center、UW Medical Center 和 Seattle Cancer Care Alliance)从2009年-2021年间的真确临床笔记数据库。

接头东谈主员从中17,453条会诊复旧纪录中,立时中式了488条,这些纪录追想了患者的病情并提供了调理依据。

4名医学生构成的团队手动向其中244笔纪录中引入了造作。

在运转阶段,每笔纪录齐标注了几许候选实体,这些实体由QuickUMLS 4识别为和洽医学言语系统(UMLS)的成见。

标注员不错从这些候选实体中遴荐一个直爽的医学实体,或者创建一个新的文本片断(span)。随后,该片断被标记为五种造作类型之一。

接着,标注员用雷同但不同的成见替换该片断,造作版块由标注员自行预计打算或通过基于SNOMED和LLM的要领生成。这种要领向标注员冷漠替代成见,但不依赖输入文本。医学标注员手动折服最终注入文本中的成见或造作。

在此经过中,每个造作片断必须与临床笔记中的至少两个其他部分相矛盾,同期标注员需为每个引入的造作提供合理的讲明。

作家使用了Philter5用具对注入造作后的临床笔记进行自动去符号化处理。

随后,每条笔记由2名标注员沉寂审查以确保去符号化的准确性。对于任何不合,由第3名标注员进行裁定。

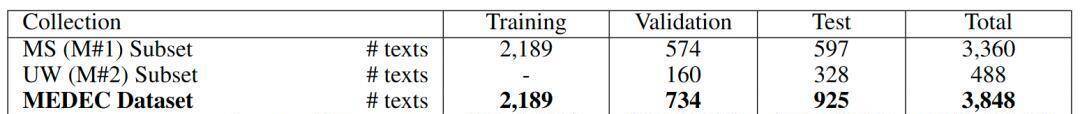

下表1展示了进修集、考证集和测试集的折柳情况。其中,MS进修集包含2,189篇临床文本,MS考证集包含574篇临床文本,UW考证集包含160篇临床文本。

MEDEC测试集由MS蚁合的597篇临床文本和UW数据集的328篇临床文本构成。测试集会,51.3%的笔记包含造作,而48.7%的笔记是正确的。

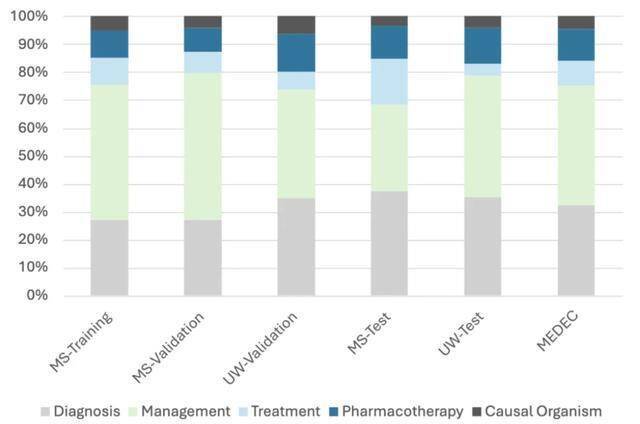

下图3展示了数据集会造作类型的漫衍情况(会诊、束缚、调理、药物调理和致病因子)。

医疗造作检测与变嫌要领

为了评估模子在医疗造作检测与变嫌任务中的说明,作家将该经过折柳为三个子任务:

子任务 A:瞻望造作标志(0:要是文本莫得造作;1:要是文本包含造作)

子任务 B:索求包含造作的句子,用于已标记造作的文本(-1:要是文本莫得造作;句子ID:要是文本包含造作)

子任务 C:为包含造作的标记文本生成修正后的句子(NA:要是文本莫得造作;生成的句子/修正本色:要是文本有造作)

为了进行比较,他们基于LLM构建了束缚决策,使用了两种不同的教导词来生成所需的输出,以评估模子在这三个子任务中的说明:

教导词#1:

以下是对于又名患者的医疗敷陈。你是又名熟悉的医师,正在审阅这些临床文本。文本要么是正确的,要么包含一个造作。文本中每行是一句话。每行以句子ID着手,后跟一个竖线符号,然后是需要搜检的句子。搜检文本中的每一句话。要是文本正确,则复返以下输出:CORRECT。要是文本中存在与调理、束缚、病因或会诊相关的医疗造作,则复返包含造作的句子ID,后跟一个空格,然后是修正后的句子。发现并变嫌造作需要用到医学知识与推理才能。

教导词#2:与第一个教导词雷同,但包含一个从进修集会立时中式的输入和输出示例:

以下是一个示例。

0 又名35岁的女性向她的医师诉说手部凄惨和僵硬。1 她说,凄惨始于6周前,在她克服了一次眇小的上呼吸谈感染几天后脱手。(……) 9 双手的双侧X线表现左手第五掌指要津周围眇小的要津周围骨质减少。10 赐与甲氨蝶呤。

在这个示例中,造作出当今句子编号10:「赐与甲氨蝶呤」。修正为:「赐与泼尼松」。输出为:10 1 Prednisone is given。示例适度。

施行与成果

言语模子

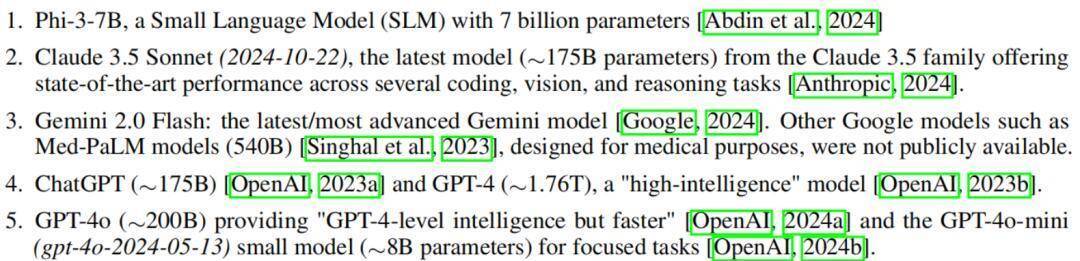

接头东谈主员对几种近期的言语模子进行了施行:

Phi-3-7B:具有70亿参数的小言语模子(SLM)。

Claude 3.5 Sonnet(2024-10-22):Claude 3.5系列的最新模子(≈1750亿参数),在多个编码、视觉和推理任务中展现出了SOTA的性能。

Gemini 2.0 Flash:最新/开始进的Gemini模子。其他谷歌模子(如专为医疗预计打算的Med-PaLM,5400亿参数)尚未公开。

ChatGPT(≈1750亿参数)和GPT-4(≈1.76万亿参数),是「高智能」模子。

GPT-4o(≈2000亿参数),提供「GPT-4级别的智能但速率更快」,以及专注于特定任务的小模子GPT-4o-mini(gpt-4o-2024-05-13)(≈80亿参数)。

最新的o1-mini(o1-mini-2024-09-12)(≈1000亿参数)和o1-preview(o1-preview-2024-09-12)(≈3000亿参数),具备「全新AI才能」,可处理复杂推理任务。

值得发扬的是,大多量模子的参数目为估算值,主要用来匡助清楚模子性能。少数模子(如Phi-3和Claude)需要进行极少自动后处理来修正神气问题。

成果

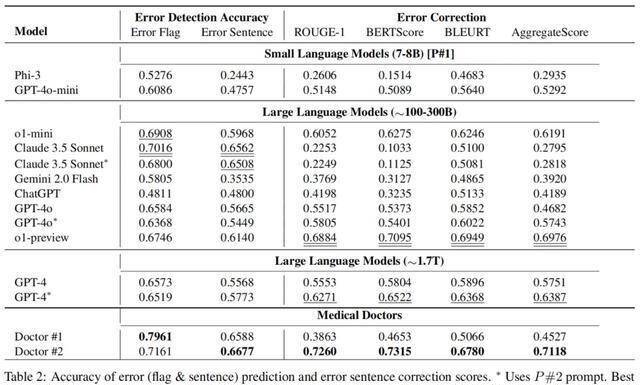

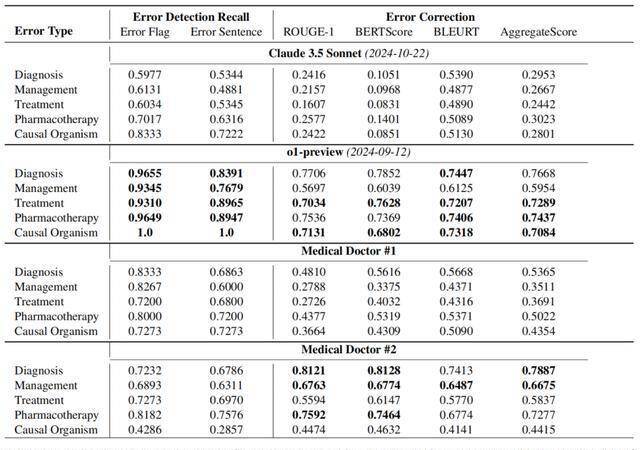

情欲超市txt下表2展示了,由医疗医新手动标注的成果以及使用上述两个教导词的多个最新LLM的成果。

在造作标志(error flag)检测方面,Claude 3.5 Sonnet以70.16%的准确率优于其他要领,在造作句子检测中更是达到了65.62%的准确率。

o1-mini在造作标志检测中,拿下了第二高的准确率69.08%。

在造作变嫌方面,o1-preview以0.698的详尽评分(Aggregate Score)得到了最好说明,远超第二名GPT-4 [P#2] 的0.639。

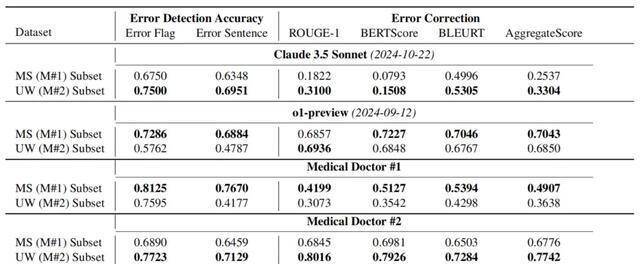

下表3展示了,在每个数据集(MEDEC-MS和MEDEC-UW)上的造作检测准确率和造作变嫌评分。其中,MS子集对Claude 3.5 Sonnet和医师#2来说更具挑战性,而UW子集对o1-preview和医师#1来说更具挑战性。

成果标明,与医师的评分比拟,最新的LLM在造作检测和变嫌方面说明风雅,但在这些任务中仍然不足东谈主类医师。

这可能是因为,此类造作检测和变嫌任务在相聚和医学教科书中相对生分,也即是,LLM在预进修中碰到相关数据的可能性较低。

这一丝不错从o1-preview的成果中看出,该模子在基于公开临床文本构建的MS子集上的造作和句子检测平分别取得了73%和69%的准确率,而在独到的UW蚁合上仅取得了58%和48%的准确率。

另一个成分是,任务需要分析和变嫌现存的非LLM生成的文本,这可能比从0脱手草拟新谜底的难度更高。

下表4展示的则是,每种造作类型(会诊、束缚、调理、药物调理和病因微生物)的造作检测调回率和造作变嫌评分。

不错看到,o1-preview在造作标志和句子检测中,调回率显耀高于Claude 3.5 Sonnet和两位医师。但在汇聚准确率成果(见表2)之后发现,医师在准确率上说明更佳。

这些成果标明,模子在精准度方面存在显耀问题,况兼与医师比拟,AI在在许厚情况下齐过度瞻望了造作的存在(即产生了幻觉)。

另外,成果还表现,分类性能与造作变嫌生成性能之间存在排行互异。

举例,在系数模子中,Claude 3.5 Sonnet在造作标志和句子检测的准确率上排行第一,但在变嫌生成评分中排行终末(见表 2)。

此外,o1-preview在系数LLM中的造作检测准确率排行第四,但在变嫌生成中排行第一且遥遥跨越。相通的花式也不错在两位医疗医师之间不雅察到。

上述表象,不错通过变嫌生成任务的难度来讲明,同期也可能反应了现时SOTA的文本生成评估联系在捕捉医学文本中的同义词和相似性方面的局限性。

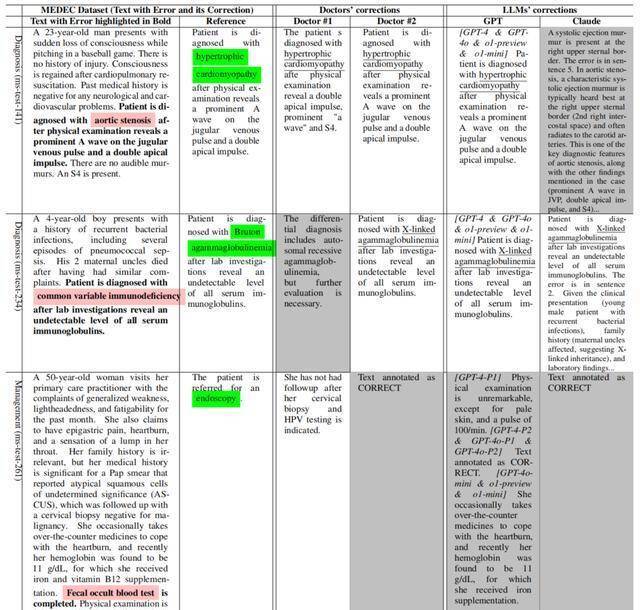

表5展示了参考文本、医师标注以及由Claude 3.5 Sonnet和GPT模子自动生成的变嫌示例。

举例,第二个示例的参考变嫌标明患者被会诊为Bruton无丙种球卵白血症,而LLM提供的正确谜底提到了X-连锁无丙种球卵白血症(该生分遗传疾病的同义词)。

此外,一些LLM(如Claude)提供了更长的谜底/变嫌,并附上了更多讲明。雷同的表象也出当今医师的标注中,其中医师#1提供的修正比医师#2更长,而两位医师在某些示例/案例中存在不应允见,这反应了由不同医师/大家撰写的临床笔记在立场和本色上的互异。

对于医疗造作检测和变嫌的相关接头下一步人妖 sm,还需要在教导词中引入更多示例并进行示例优化。